Résumé :

Résumé :

Le travail des agences d’expertise sanitaire est de plus en plus fréquemment critiqué dans la presse, souvent par des chercheurs qui leur reprochent de ne pas assez prendre en compte les travaux qui déclarent avoir identifié des risques pour la santé. Ces divergences de vue sont souvent interprétées comme une démonstration du fait que les agences seraient trop sensibles au lobbying des industriels. Mais est-ce la seule explication possible ? En fait, il est tout-à-fait normal que les experts n’aient pas forcément le même point de vue que les chercheurs. En effet, leur travail nécessite d’arbitrer entre deux types d’expérimentations aux buts et méthodes contradictoires :

- les expérimentations toxicologiques, exigées en préalable à la mise en marché des produits potentiellement dangereux, en vertu du principe de précaution

- les expérimentations scientifiques réalisées a posteriori par les chercheurs spécialistes des risques environnementaux.

Ces différences d’approche se traduisent par des priorités différentes sur le plan statistique : minimiser le risque de 2ème espèce (bêta) dans le premier cas, et le risque de 1ère espèce (alpha) pour les secondes. Or le mode de raisonnement des chercheurs, ainsi que le mode d’évaluation de leur travail, les poussent à privilégier alpha, ce qui oriente inévitablement l’interprétation de leurs publications. Il serait donc important que les agences sanitaires s’expliquent mieux sur leurs différences méthodologiques avec la recherche.

Nous avons vu, dans notre série d’article « La pêche aux alphas », les paradoxes statistiques liés au fameux alpha, le risque de 1ère espèce[1]. S’il s’appelle ainsi, on se doute bien qu’il a un acolyte appelé beta, le risque de 2ème espèce. Qui signifie-t-il, et quelle importance a-t-il pour l’analyse des résultats scientifiques ? C’est ce que nous allons voir maintenant.

alpha et bêta : les deux risques antagonistes de l’expérimentation

Reprenons l’exemple d’un épidémiologiste qui travaille sur les effets sanitaires éventuels d’un pesticide, en mesurant la prévalence (fréquence) d’une maladie dans deux populations comparables, l’une exposée, et l’autre non exposée à ce pesticide. Les phénomènes biologiques sont par nature aléatoires. Même si le produit étudié était totalement inoffensif, il est très peu probable qu’il trouve exactement le même résultat dans les deux populations. Imaginons qu’il trouve par exemple une prévalence de 5% dans la population témoin (non exposée) et de 6% dans la population exposée : toute la question va être de savoir si cette différence est significative (c’est à-dire due au facteur environnemental), ou simplement causée par le hasard de l’échantillonnage.

C’est là qu’interviennent les tests statistiques : en faisant des hypothèses sur la distribution de la variable mesurée (par exemple en supposant qu’elle suit une loi normale, la fameuse courbe de Gauss), il devient possible de calculer ce que l’on appelle la probabilité critique, c’est-à-dire la probabilité d’obtenir cette différence de prévalence de 1%, par le seul effet du hasard. En termes de décision, cette probabilité critique mesure donc le risque d’attribuer par erreur au pesticide un effet qu’il n’a pas : c’est ce risque que l’on appelle le risque de 1ère espèce, appelé par convention alpha.

On considère qu’un résultat est significatif si sa probabilité critique est inférieure à 5%, et hautement significatif si elle est inférieure à 1%. Pourquoi ne pas retenir des seuils encore plus bas, si on veut être sûr de ne pas se tromper ? Pour une raison toute simple : plus on réduit le risque de 1ère espèce, plus on augmente la différence nécessaire entre la population témoin et la population exposée pour déclarer le résultat significatif.

Revenons à notre exemple précédent : si on se fixe un risque de 1ère espèce à 1% au lieu de 5%, on ne considérera le résultat comme significatif que si l’écart de prévalence entre la population témoin et la population exposée est supérieur à 20% (par exemple). Si le produit étudié n’a qu’un effet de 10%, ce qui est déjà important pour une maladie grave, on va donc considérer à tort qu’il n’a pas d’effet : on est alors tombé dans le risque de 2ème espèce, que l’on appelle bêta. En pratique, on parle plus souvent de la probabilité inverse (1-bêta), que l’on appelle la puissance de l’expérimentation (sa probabilité de fournir un résultat significatif).

On comprend donc bien que le chercheur doit continuellement naviguer entre 2 risques :

- Celui d’attribuer par erreur un effet à un produit inoffensif (le risque de 1ère espèce alpha)

- Celui de ne pas identifier un effet nocif réel, mais faible (le risque de 2ème espèce bêta)

De plus, ces deux risques sont antagonistes : si on réduit l’un, on augmente l’autre, à taille de population étudiée égale. La seule possibilité pour réduire simultanément les deux risques est d’augmenter la taille de la population étudiée, mais on est vite limité par le temps nécessaire, et les coûts supplémentaires que cela implique.

Dans le monde réel, les scientifiques doivent donc choisir le risque qu’ils veulent réduire (et donc celui qu’ils acceptent de laisser augmenter). Quel risque est le plus important, alpha ou bêta ? Cela dépend évidemment du but de l’expérimentation réalisée. Et c’est à cause de cela que le point de vue des chercheurs oriente inévitablement la perception des risques épidémiologiques.

1. Les chercheurs préfèrent les petits alphas aux petits betas

Dans nos articles sur la pêche aux alphas, nous avions étudié le cas de publications réalisées par des chercheurs. Par définition, un chercheur est formé pour générer des connaissances nouvelles. Pour cela, il va monter des expériences dont il va vérifier qu’elles confirment bien sa théorie, c’est à-dire mettre en évidence les effets observables de son hypothèse. Pour lui, un « bon » résultat est donc un résultat significatif, qui va démontrer que ses hypothèses ont bien les effets prévus.

Il existe une autre catégorie de travail scientifique, moins prestigieuse, mais basée sur les mêmes méthodes, qui a des critères de qualité inverses. Il s’agit des expérimentations toxicologiques destinées à l’autorisation de mise sur le marché des produits potentiellement dangereux, comme les médicaments ou les pesticides. Dans ces expériences, requises par le principe de précaution, le but est au contraire de montrer que le produit étudié n’a pas d’effet ! Le risque de 1ère espèce n’a donc aucune importance, puisque le « but » est au contraire de ne pas trouver de résultat significatif. Par contre il faut être sûr qu’il n’existe pas d’effet, même faible : dans ce type d’expérimentation, c’est le risque de 2ème espèce bêta qui doit être très faible, et donc, ce qui revient au même, la puissance (1-bêta) doit être très élevée.

Pour un même sujet, traité avec les mêmes méthodes statistiques, nous avons donc deux approches différentes :

- les expérimentations toxicologiques, où un « bon » résultat est un résultat non significatif, mais obtenu avec une puissance élevée (donc un petit bêta)

- celles réalisées par les chercheurs, pour qui un « bon » résultat est un résultat significatif (avec un petit alpha), quelle que soit la puissance 1-bêta.

Dans notre article sur la mortalité des agriculteurs[2], nous avons vu un exemple particulièrement frappant de cet état d’esprit des chercheurs : il s’agissait de la publication sur les causes de mortalité des agriculteurs de la cohorte AHS[3]. Avec l’indicateur le plus couramment utilisé, le Standardized Mortality Ratio, les chercheurs n’avaient trouvé aucune augmentation significative de la mortalité par cancer chez les utilisateurs de pesticides. Cela constitue un résultat majeur, à l’opposé des idées reçues, s’il est obtenu avec une puissance suffisante pour garantir sa solidité. Mais les auteurs n’ont même pas jugé utile d’indiquer le risque de 2ème espèce de leur analyse. A la place, ils ont préféré mettre en avant les résultats d’un autre indicateur, le relative Standardized Mortality Ratio, qui était pourtant ininterprétable vu le contexte complexe de leur étude… mais avait pour seul mérite de donner des résultats significatifs ! Il s’agit d’un exemple d’une situation où le goût des chercheurs pour les résultats significatifs influe, sans que ce soit forcément volontaire, sur la perception des résultats : un résultat significatif, même incompréhensible ou incertain, est préféré à un résultat rassurant non significatif, dont on n’a même pas vérifié la puissance.

2. Quand un chercheur cherche, il finit toujours par trouver… surtout si c’est un épidémiologiste

On connait la vieille boutade attribuée au Général de Gaulle : « Des chercheurs qui cherchent, on en trouve, mais des chercheurs qui trouvent, on en cherche » … mais ça, c’était avant ! Cela reste vrai en physique nucléaire, et de façon générale dans les sciences les plus « dures », où les faits sont particulièrement têtus. Mais ce n’est plus du tout le cas dans les sciences humaines ou du vivant, où les statistiques sont devenues plus importantes que les données. Nous en avons vu bien des exemples dans nos articles précédents : dans ces disciplines, et particulièrement en épidémiologie, discipline devenue entièrement statistique, si on cherche avec suffisamment de persévérance, on finit forcément par trouver des résultats significatifs : il suffit de faire 20 tests statistiques sur un produit inoffensif, pour avoir un résultat significatif. Toute la question est ensuite de savoir si ces résultats sont « vraiment » significatifs, ou simplement obtenus grâce au risque alpha. Or il n’y a aucun moyen d’en être sûr quand on n’a qu’un résultat isolé. Quand il y a un doute sur la validité d’un résultat, la seule méthode infaillible pour en avoir le cœur net est de refaire une expérience du même type sur une autre population, ou un autre jeu de données :

- si on retrouve exactement le même résultat que la 1ère fois, le résultat sera définitivement validé.

- si on retrouve de nouveau des résultats significatifs, mais différents, c’est que la 1ère publication était un cas de pêche aux alphas.

3. Les chercheurs n’aiment pas se répéter, et les revues scientifiques encore moins

Nous l’avons vu dans les articles « Pêche aux alphas 1 et 2 », on peut avoir des soupçons de pêche aux alphas quand deux conditions sont réunies :

- La proportion de résultats significatifs dans les résultats présentés est peu supérieure à 5%

- Ces résultats ne montrent aucune tendance cohérente, avec par exemple des résultats contradictoires

La publication sur les produits cancérigènes dans les poussières d’appartements, que nous avons vu dans l’article « Pêche aux alphas, niveau 2[4] » en était un exemple particulièrement frappant : le nombre de résultats significatifs était parfaitement conforme au risque de 1ère espèce, et tous les pesticides testés avaient selon les sites une liaison tantôt négative, tantôt positive, avec la maladie étudiée. Mais nous en avons vu aussi d’autres exemples :

- Dans notre article sur l’effet des insecticides organophosphorés sur le QI[5]:

- Une des publications citées[6] faisait état d’une baisse significative du QI des enfants noirs ou hispaniques exposés…mais aussi de meilleures performances au test WISC (un autre test sur les capacités intellectuelles des enfants), pour les enfants blancs exposés !

- L’autre publication citée[7] avait trouvé une liaison négative entre QI et exposition aux organophosphorés, … mais par rapport à un groupe non exposé qui avait un QI de 107, tous les groupes exposés gardant un QI de 100, donc normal

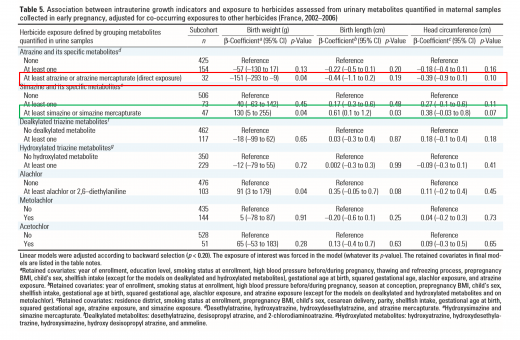

- Dans l’article le plus fréquemment cité à l’appui d’un effet perturbateur endocrinien de l’atrazine[8], cher à Elise Lucet[9] mais aussi à La Recherche[10], les auteurs ont certes trouvé un périmètre cranien réduit (à un niveau d’ailleurs non significatif selon les seuils habituels) pour les enfants exposés in utero à l’atrazine. Mais ils ont aussi trouvé un effet inverse, avec le même niveau de significativité pour l’exposition à la simazine, une molécule très proche de l’atrazine.

Tableau 5 de Chevrier et al. 2011 : les auteurs trouvent une liaison négative entre exposition in utero à l’atrazine et taille des enfants à la naissance(résultat encadré en rouge). Cet effet n’est significatif que pour le poids à la naissance (birth weight), et seulement pour les enfants dont la mère a été exposée à l’atrazine mercapturate, ce qui est le signe d’une exposition directe (par opposition à la consommation d’eau de boisson contenant des résidus d’atrazine, qui ne donne aucun effet statistiquement significatif). Curieusement, l’exposition à la simazine donne des résultats inverses (résultat encadré en vert) : les enfants exposés in utero à la simazine mercapturate sont significativement plus grands que la moyenne, et ceux qui ont été exposés par la consommation d’eau de boisson maternelle sont légèrement plus grands, sans que ce soit significatif. D’un point de vue toxicologique, il est pour le moins étrange que deux molécules aussi proches aient des effets opposés. Ce résultat demanderait donc une confirmation significative sur une autre population avant d’être validé. Par ailleurs, on note en passant que ces résultats « presque significatifs » et contradictoires ne concernent que les femmes utilisant elle-même de l’atrazine ou de la simazine. Ils sont pourtant souvent cités dans les medias (non démentis par les auteurs), comme attestant d’effets des résidus d’atrazine dans les eaux de boisson.

Face à des résultats aussi peu cohérents, il est permis de s’interroger sur leur significativité réelle. Faut-il publier des résultats de ce type ? C’est une question de choix éditorial, que chaque comité de lecture doit assumer en fonction de son niveau d’exigence. On note d’ailleurs que ces 3 publications, choisies en raison de leur retentissement médiatique, proviennent toutes de la même revue, Environmental Health Perspectives. En tout cas, à partir du moment où des résultats de ce type ont été publiés, ils auraient nécessité une confirmation sur un autre jeu de données, avant d’être acceptés définitivement. Il est d’ailleurs caractéristique de noter qu’à chaque fois les auteurs en convenaient dans la discussion…mais que cette confirmation n’a jamais été réalisée !

En effet, c’est là que l’on bute sur une autre caractéristique des chercheurs : ils n’ont aucun intérêt à confirmer une expérience déjà faite. Leur carrière est évaluée à l’aune du nombre et de l’originalité de leurs publications. Chercher à confirmer un résultat incertain en répétant à l’identique une expérience est pour eux une double perte de temps : d’une part, pendant ce temps, ils ne travaillent pas à créer des connaissances nouvelles. D’autre part, il leur serait très difficile de trouver une revue qui accepterait de publier un article relatant simplement la confirmation d’une étude déjà réalisée. La plupart du temps, ils vont plutôt choisir de continuer à travailler sur le même thème, mais en y traitant des questions nouvelles. Cela signifie qu’ils vont avoir un protocole expérimental nouveau, qui différera de leur étude précédente, et ne permettra donc pas de confirmer la significativité réelle du résultat initial. Bien entendu, cette nouvelle expérience donnera probablement à son tour des résultats significatifs qui seront considérés comme une confirmation de la première étude… mais qui peuvent tout autant résulter du risque de 1ère espèce !

Les contraintes inhérentes à l’évaluation des chercheurs et à l’impact factor (l’audimat des revues scientifiques) incitent donc inévitablement :

- à une survalorisation des résultats significatifs, même incertains ou incohérents, et jamais confirmés par la suite dans des conditions exactement comparables

- à une sous-évaluation des résultats non significatifs, dont la puissance n’est pratiquement jamais vérifiée.

Tout le difficile travail des experts chargés de l’évaluation des risques va donc être de juger de la cohérence des résultats, et de prononcer un avis qui doit arbitrer entre la crédibilité :

- de résultats significatifs rarement confirmés

- de résultats non significatifs dont on ne connait pratiquement jamais la puissance.

Le travail de synthèse des chercheurs suffit-il pour cela ? A l’évidence, non. Une observation très simple suffit pour s’en rendre compte : les revues bibliographiques publiées dans la presse scientifique comprennent toujours un inventaire (normalement exhaustif) des travaux publiés, séparant bien les résultats significatifs des résultats non significatifs ; elles y ajoutent souvent des meta-analyses, permettant de vérifier si un regroupement des résultats non significatifs permet d’obtenir un résultat significatif. Mais il est beaucoup plus rare qu’elles comprennent une analyse de la puissance des résultats non significatifs. Pourtant, cette information devrait être aussi importante, pour une expertise, que celles portant sur les résultats significatifs. Par analogie avec l’expertise judiciaire, cela revient à évaluer seulement la fiabilité des témoignages à charge, en négligeant tous les témoignages à décharge, quel que soit leur nombre et leur précision.

Le travail des experts repose donc sur les mêmes données que celui des chercheurs, mais il doit (ou devrait) les examiner avec un regard différent :

- d’une part parce qu’il doit procéder à une évaluation de la valeur des résultats non significatifs, un travail rarement fait par les chercheurs eux-mêmes

- d’autre part parce qu’il doit être mené avec un regard critique sur les publications scientifiques, pour ne pas surévaluer la robustesse des résultats significatifs

Il n’y a donc rien d’étonnant à ce que l’avis des agences d’expertise puisse diverger de celui des chercheurs spécialistes du domaine étudié… et, quand cela se produit, à ce que les experts soient généralement moins alarmistes que les chercheurs ! L’actualité récente nous en offre de nombreux exemples. Nous l’avons vu déjà à propos de la question de la mortalité par cancer chez les agriculteurs : la synthèse bibliographique commandée par l’EFSA (agence d’expertise) conclut qu’il n’y a aucune preuve de surmortalité par cancer chez les agriculteurs, pour aucune localisation de tumeur, alors que l’expertise collective de l’INSERM (organisme de recherche) penche en faveur d’une surmortalité pour plusieurs localisations. Le cas le plus médiatisé récemment est celui du glyphosate, classé récemment comme cancérigène probable pour l’homme par le CIRC (organisme de recherches), contre l’avis de l’EFSA et de l’EPA (l’agence sanitaire américaine).

Face à ces divergences récurrentes, certains ont bien sûr une explication toute trouvée : les agences sanitaires seraient trop sensibles au lobbying de l’industrie[11]. Face à ces insinuations, il est bien dommage que les agences ne communiquent pas plus clairement sur leurs méthodes pour faire valoir leur point de vue. Il y d’autant plus urgence que la presse leur oppose de plus en plus des chercheurs se présentant comme lanceurs d’alerte. Le cas du glyphosate aurait pu être une bonne occasion pour cette explication de texte, puisqu’en l’occurrence les chercheurs du CIRC avaient tiré les premiers, avant l’EFSA en Europe et l’EPA aux Etats-Unis. Mais l’occasion a été manquée, comme nous le verrons dans un autre article.

Philippe Stoop

[1] http://www.forumphyto.fr/2016/04/01/la-peche-aux-alphas-non-ce-nest-pas-un-poisson-davril/

http://www.forumphyto.fr/2016/05/19/la-peche-aux-alphas-niveau-2-cours-de-perfectionnement/

[2] http://www.forumphyto.fr/2016/06/21/les-pesticides-provoquent-ils-vraiment-des-cancers-chez-les-agriculteurs/

[3] http://aje.oxfordjournals.org/content/173/1/71.long

[4] http://www.forumphyto.fr/2016/05/19/la-peche-aux-alphas-niveau-2-cours-de-perfectionnement/

[5] http://www.forumphyto.fr/2015/09/25/pesticides-qi-euros-les-calculs-acrobatiques-du-cnrs/

[6] Engel SM, Wetmur J, Chen J, et al., 2011 : Prenatal exposure to organophosphates, paraoxonase 1, and cognitive development in childhood.Environ Health Perspect. (119) 1182–1188

[7] Bouchard MF, Chevrier J, Harley KG, et al. (2011) : Prenatal exposure to organophosphate pesticides and IQ in 7-year-old children. EnvironHealth Perspect. (119) 1189–1195

[8] https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3222984/

[9] http://www.pseudo-sciences.org/spip.php?article2614#L’atrazine dans l’eau du robinet : petits arrangements avec la réalité

[10] http://www.forumphyto.fr/2016/03/09/pesticides-et-sante-accablant-le-dossier-de-la-recherche/

[11] http://www.lemonde.fr/planete/article/2016/03/28/roundup-le-pesticide-divise-l-union-europeenne-et-l-oms_4891222_3244.html#huit-anchor-les-experts

http://www.generations-futures.fr/glyphosate/un-avis-de-lefsa-scandaleux/